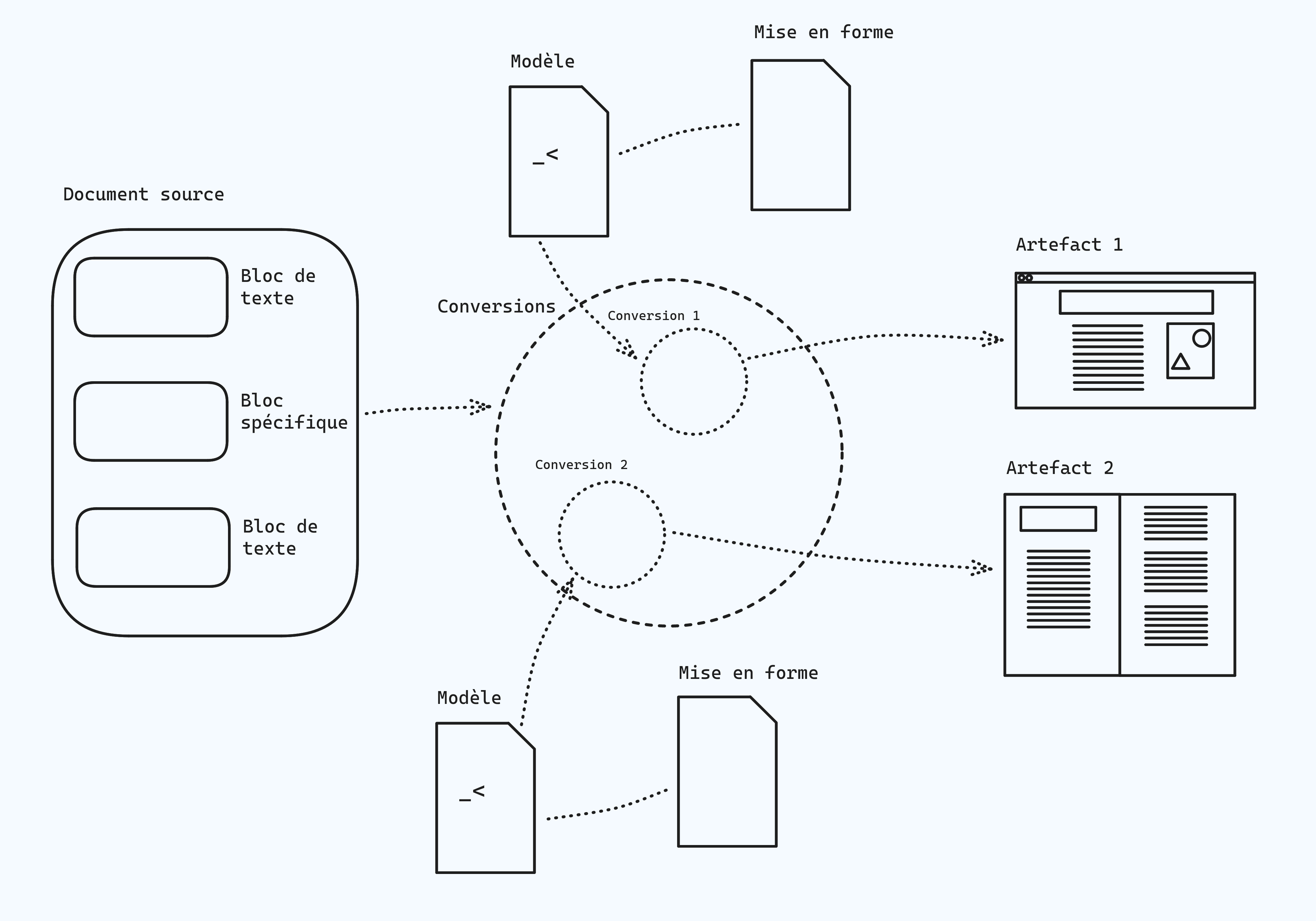

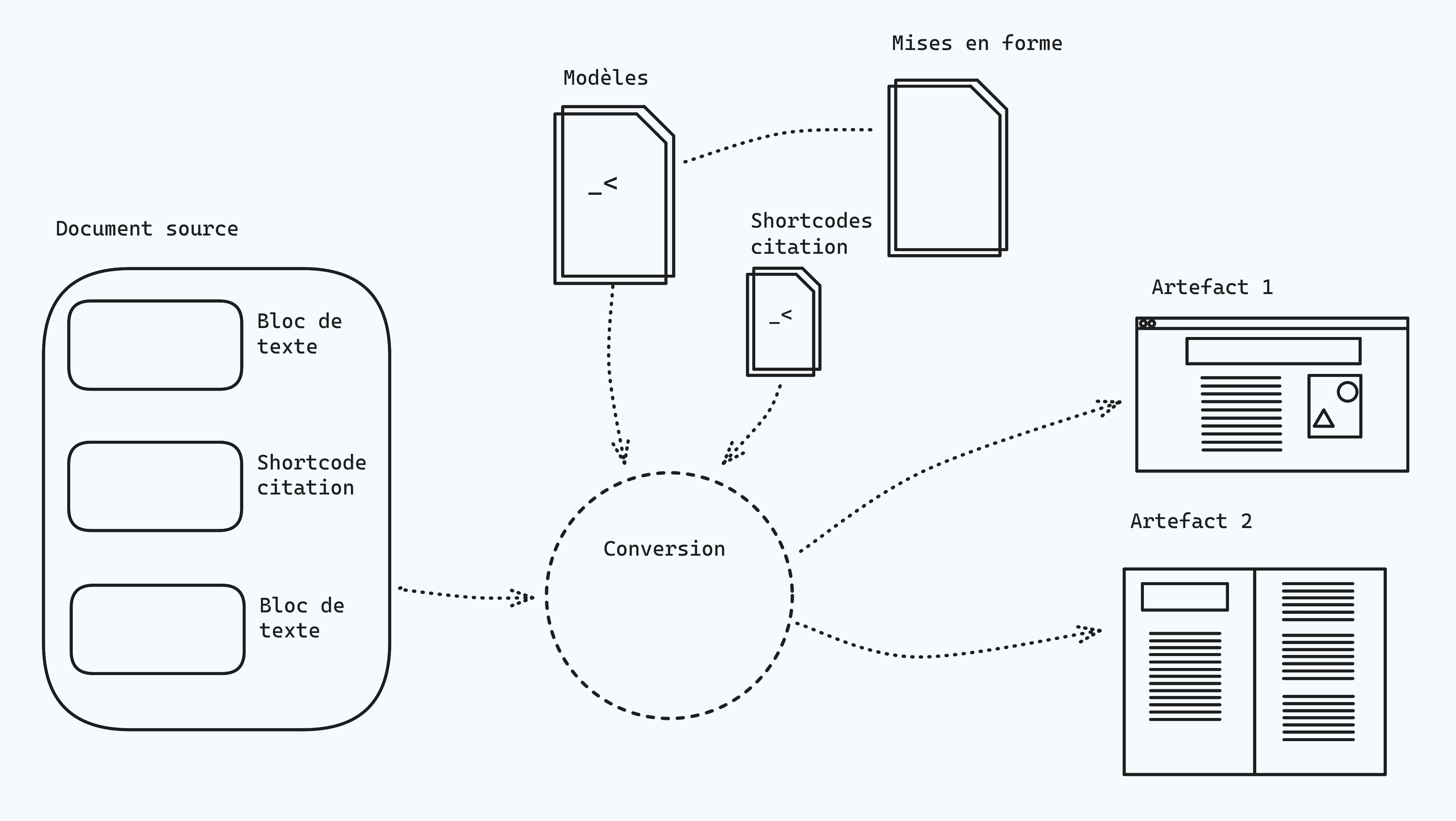

Après le livre, l’édition, le numérique et le format, il s’agit désormais d’appréhender les processus d’édition classiques en tant qu’ils sont un assemblage de logiciels et de programmes, de pratiques incarnées par des personnes, et de méthodes et de protocoles, afin de prolonger l’analyse de processus d’édition non conventionnels en tant qu’ils peuvent être une imbrication du façonnage de processus et de textes. Ce que nous nommons fabrique et que nous développons en tant que concept est ce double mouvement entremêlé de travail sur des textes et de constitution de processus techniques.

Une fabrique d’édition est un processus technique et dispositif qui comprend autant l’édition de textes que la mise en place ou l’agencement d’outils permettant ce travail d’édition. Fabriquer des éditions, éditer des fabriques, nous avons déjà observé ce phénomène dans plusieurs initiatives telles qu’exposées dans les précédents chapitres. Le concept de fabrique rassemble plusieurs principes que nous détaillons ici, nous explicitons comment ils s’incarnent dans les concepts et projets qui suivent. En plus du double mouvement d’édition de textes et de construction de chaînes, il s’agit aussi de dévoiler et de révéler les rouages des processus et de comprendre l’architecture technique et épistémologique de ces composants ou micro-programmes. Dans le champ de l’édition, comprenant dans ce chapitre les métiers du design graphique, nous observons le développement de méthodes et d’outils qui ne reposent pas sur les logiciels. Les acteurs et les actrices de pratiques d’édition qui adoptent des démarches logiciellement décentrées — et donc qualifiées de non conventionnelles — remettent régulièrement en cause les outils majoritairement utilisés ainsi que ceux qu’elles ont elles-mêmes créés, le choix est fait d’une plus grande malléabilité et découvrabilité. Ce phénomène comprend aussi une dimension réflexive et critique, les pratiques sont en effet interrogées dans leurs dispositions techniques au moment de leur mise en place. Il ne s’agit pas seulement d’avoir recours à des logiciels alternatifs, mais de sortir de la rhétorique des solutions techniques.

Quelle est l’origine de cet entremêlement des actes d’édition et de la création de chaînes d’édition ? À quel point un acte d’édition peut-il également être une opération de construction d’un processus ?

Pour répondre à ces questions nous définissons d’abord ce qu’est le logiciel, en tant qu’objet qui s’est constitué avec l’informatique puis le numérique, en analysant le changement de paradigme induit. Le logiciel, tel que nous le connaissons aujourd’hui, est, d’une certaine façon, l’anti-fabrique. Il y a toujours eu des pratiques d’écriture et d’édition — au sens large — sans logiciel, mais quelles sont-elles ? Pour les expliciter nous observons deux moments de l’histoire de l’informatique et du numérique, d’un côté les débuts des interfaces graphiques dite utilisateur, et de l’autre l’émergence du mouvement dit du CSS print. Pourquoi vouloir se débarrasser du logiciel qui semble pourtant faciliter le travail éditorial ? C’est l’objet de l’étude de cas sur C&F Éditions, où des livres sont fabriqués sans logiciels. Nous définissons enfin le concept de fabrique et le phénomène de fabrique d’édition, en analysant les approches théoriques de Tim Ingold et de Vilèm Flusser, et en puisant dans les précédents chapitres. Pour expliquer ce double mouvement où des processus d’édition sont créés en même temps que des textes sont édités, nous réalisons une double étude de cas autour d’une fabrique d’édition multi-formats et d’une autre multimodale, les deux étant des expérimentations réalisées dans le cadre de cette thèse.

#5.1. Les chaînes d’édition : composer avec les logiciels</>

Commit : 07f3e07

Source : https://src.quaternum.net/t/tree/main/item/content/p/05/05-01.md

</>

Commit : 07f3e07Source : https://src.quaternum.net/t/tree/main/item/content/p/05/05-01.md

Quels modèles sont adoptés dans le domaine de l’édition, et comment peuvent-ils être critiqués en tant que chaîne d’édition ? Cette section se focalise sur le rôle du logiciel comme engendrant un certain enfermement et une forme d’uniformatisation des pratiques d’édition. Avant de déterminer des cadres de modélisation qui échappent au carcan du logiciel, il faut définir à quoi il correspond. Autrement dit, il s’agit ici d’analyser à quel point le logiciel et son usage empêchent la réalisation du concept de fabrique, sur les plans suivants : fabrication du sens via l’utilisation du numérique ou de l’informatique, construction d’une chaîne d’édition qui répond à des contraintes diverses, malléabilité des composants de cette chaîne.

Dans un premier temps nous établissons donc de quoi le logiciel est-il le nom, en le définissant en soi tout en raccrochant son histoire à celle de l’édition, celle-ci ayant été aux premières loges de l’informatisation de nos sociétés. Cette nécessité de tout transformer en rendu graphique se traduit par un désir de tout interfacer, c’est ce que nous analysons dans la deuxième section. À ce stade il faut noter à quel point les logiciels créent de fait une opacité, à la fois en termes de création de sens mais aussi dans leurs rouages — les deux étant liés. Enfin, un mouvement conduit à une plus forte opacité encore, avec le développement d’applications en ligne.

Cette section a comme objectif de relever les limites éditoriales imposées par le logiciel, et ainsi de pouvoir envisager des actes éditoriaux sémantiques comme moteurs des processus.

#5.1.1. De quoi le logiciel est-il le nom ?

Le logiciel est communément considéré comme un outil numérique permettant de réaliser des opérations ou des actions grâce à une machine informatique (ordinateur et autres dispositifs numériques), dont les domaines d’utilisation sont divers, et dont la création ou la compréhension est réservée à des spécialistes — son fonctionnement étant jugé à la fois complexe et puissant, voire opaque. Si le logiciel mérite une définition plus précise, notons que ces considérations donnent déjà une représentation utile de cet objet numérique.

Ensemble des programmes, procédés et règles, et éventuellement de la documentation, relatifs au fonctionnement d’un ensemble de traitement de données.

La raison d’être du logiciel est donc de traiter des informations, pour cela un logiciel regroupe des programmes qui agissent sur des données, ces programmes étant eux-mêmes une série d’algorithmes. Nous reprenons ici la distinction opérée par Anthony Masure entre l’algorithme, le programme informatique, le logiciel et l’application (Masure, 2014, p. 167-169) Masure, A. (2014). Le design des programmes: des façons de faire du numérique. Thèse de doctorat, Université Panthéon-Sorbonne. Consulté à l’adresse http://www.softphd.com/ . Un algorithme est une suite d’opérations, une recette appliquée sur des données. Le programme est l’implémentation d’un ou plusieurs algorithmes dans un langage de programmation. Le programme est exécuté par un ordinateur à travers une série de fonctions, alors que l’algorithme est un calcul abstrait. Le logiciel est un ensemble de programmes, rassemblés sous une même entité, comprenant une documentation.

Les logiciels sont la colle invisible qui assure la cohésion de l’ensemble.

Un logiciel est censé répondre à des objectifs précis, il est ainsi conçu pour satisfaire à un ou plusieurs besoins déterminés, et s’inscrit le plus souvent dans une logique économique que nous qualifions de solutionnisme technologique (Morozov, 2014) Morozov, E. (2014). Pour tout résoudre, cliquez ici: l’aberration du solutionnisme technologique. Fyp. . Il faut distinguer plusieurs types de logiciels, et notamment ceux qui réalisent des opérations directement sur un matériel et ceux qui traitent de l’information. Dans le premier cas il s’agit des outils permettant de faire fonctionner un ordinateur, dans le second cas ce sont des logiciels comme des traitements de texte, des logiciels de dessin ou encore de composition typographique — pour prendre des exemples dans le domaine de l’édition. Ils sont tous exécutés sur un ordinateur. L’apparition de nouveaux dispositifs en dehors du champ des machines informatiques de bureau ou personnelles (plus ou moins portables), comme les téléphones (intelligents) et les tablettes, a introduit une nouvelle notion : l’application. Cette précision est importante, tant l’application est un logiciel auquel un certain nombre de contraintes (économiques, techniques, légales, etc.) est appliqué. Avec la notion d’application vient la question de l’accès et de la diffusion d’outils informatiques, puisqu’en effet une application est rendue accessible par un tiers qui impose des règles spécifiques, réduisant les possibilités du développement de logiciels. Le logiciel et l’application sont donc deux objets numériques qui résultent d’une volonté de résoudre des problèmes, et de le faire dans des environnements contraints ou contraignants, ils influencent donc nos vies.

[Les logiciels portent en eux] un ensemble de pratiques et de conventions sociales et économiques. Il en résulte une nouvelle forme de contrôle, non coercitive mais néanmoins puissante.

La place que prend le logiciel dans nos sociétés entraîne un intérêt certain et devient ainsi un nouvel objet d’étude pour les sciences humaines et sociales. Il fait même l’objet d’un champ d’études avec la naissance des software studies (ou études logicielles en français), dont les initiateurs sont Friedrich Kittler (Kittler, 1995) Kittler, F. (1995). There is No Software. CTheory. 147–155. Consulté à l’adresse https://journals.uvic.ca/index.php/ctheory/article/view/14655 , Lev Manovich (Manovich, Beauvais & al., 2010) Manovich, L., Beauvais, Y. & Tribe, M. (2010). Le langage des nouveaux médias. Les Presses du réel. ou Matthew Fuller (Fuller, 2003) Fuller, M. (2003). Behind the blip: essays on the culture of software. Autonomedia. . Le positionnement de ce champ d’études nous apporte des informations précieuses pour qualifier le logiciel : il s’agit d’étudier le logiciel en tant qu’artefact et en tant qu’il a des effets culturels et sociaux. Avant les software studies d’autres domaines ont étudié et étudient le logiciel, mais pas en tant qu’objet singulier. À la suite des études logicielles un autre domaine émerge : les critical code studies (ou études critiques du logiciel) (Marino, 2020) Marino, M. (2020). Critical Code Studies. MIT Press. , focalisées cette fois sur les implications politiques du code lui-même.

Cette délimitation nous permet de comprendre que le logiciel est un objet numérique qui comprend des langages et des structures logiques. L’omniprésence du logiciel dans nos sociétés en fait un objet qui structure notre monde. Son ubiquité et ses implications politiques justifient de l’étudier en profondeur.

Software studies is, or can be, the work of fashioning documentary methods for recognizing and recovering digital histories, and the cultivation of the critical discipline to parse those histories against the material matrix of the present. Software studies is understanding that digital objects are sometimes lost, yes, but mostly, and more often, just forgotten. Software studies is about adding more memory.

Les liens sont forts entre le développement du logiciel et le domaine de l’édition, les premiers logiciels ayant été des outils de gestion du texte ou de l’image, dans une perspective de publication. Avant d’aborder cette question, il convient d’étudier une condition importante de cet usage massif de cette forme d’objet numérique, l’interface graphique.

#5.1.2. Naissance des interfaces graphiques

Lorsque le terme de logiciel est évoqué, il est majoritairement question d’interface, ou comment permettre une interaction avec les composants d’un ordinateur, et plus précisément permettre aux humains d’interagir avec des programmes, ces derniers exécutant des algorithmes pour traiter des données. L’interface semble donc incontournable pour utiliser un ordinateur, afin de ne pas devoir apprendre à taper des 0 et des 1 pour exprimer des instructions — pour caricaturer. Les interfaces informatiques prennent des formes diverses, Florian Cramer et Matthew Fuller établissent une typologie (Cramer & Fuller, 2008, p. 149) Cramer, F. & Fuller, M. (2008). Interface. Dans Fuller, M. (dir.), Software studies: a lexicon. (pp. 149–153). The MIT Press. dont nous retenons la distinction entre des interfaces qui permettent une circulation de l’information dans la machine (entre les composants) ou entre des machines, et des interfaces utilisateur. Nous nous concentrons sur ces interfaces utilisateur, afin de déterminer quels sont leur rôle et leurs implications.

Les interfaces utilisateur sont la condition d’utilisation de l’ordinateur, et donc du numérique. Étant des éléments de langage, elles introduisent une assymétrie qui conduit à un décalage entre les fonctions d’un logiciel et les façons de les appeler et de les utiliser.

Similar to both its meaning in chemistry and to the meaning of “language,” “interfaces” are the point of juncture between different bodies, hardware, software, users, and what they connect to or are part of. Interfaces describe, hide, and condition the asymmetry between the elements conjoined.

Les interfaces utilisateur prennent elles-mêmes plusieurs formes, notamment textuelles avec les interfaces en ligne de commande via un terminal — comme évoqué précédemment pour l’utilisation de PandocVoir 4.3. Le langage de balisage léger Markdown : entre interopérabilité et compromis —, ou graphiques avec la symbolisation visuelle omniprésente dans nos utilisations communes des terminaux numériques. Les interfaces textuelles prennent donc la forme d’une série d’instructions exprimées par des mots, et sont censées être moins ambigües qu’une série de menus, de boutons ou de diverses fonctions figurées par des éléments graphiques. L’interface graphique — ou interface graphique utilisateur, GUI en anglais — a donc autant un rôle déterminant pour l’usage de programmes informatiques que des effets conséquents sur la relation de fait biaisée entre la machine et la personne qui l’utilise. D’un côté elle traduit les possibilités programmatiques du logiciel dans un langage censé être accessible et rapidement compréhensible, de l’autre elle produit un fort décalage entre les fonctions réelles du logiciel et leur identification ou leur prise en main par la personne qui en a besoin — ou dont le besoin est suscité. En tant qu’artifice elle entraîne l’utilisateur et l’utilisatrice dans un parcours spécifique. Pour reprendre le cas du traitement de texte déjà amplement abordéVoir 4.1. Les formats dans l’édition : pour une sémantique omniprésente, les fonctions de mise en forme graphique sont par exemple par défaut beaucoup plus mises en avant que les possibilités de structuration sémantique. Ainsi il semble logique que les personnes qui utilisent un traitement de texte soient amenées à envisager le rendu graphique de leur texte avant son agencement logique.

Les interfaces graphiques ne sont pas mauvaises en soi, nous ne tombons pas ici dans l’écueil du rejet de tout interfaçage graphique — même si les interfaces textuelles apportent néanmoins une double dimension d’univocité et de maîtrise. Elles font d’ailleurs l’objet de métiers désormais bien identifiés, tels que les designers d’interfaces utilisateur (designers UI) ou les designers d’expérience utilisateur (designers UX), consacrés à la définition, l’élaboration et la production d’interfaces (majoritairement graphiques) permettant l’utilisation de logiciels au sens large. L’enjeu de ces métiers est de négocier au mieux le décalage entre les fonctions et leur usage comme dit plus haut, mais aussi parfois d’influencer le cheminement parmi ces fonctions. D’un côté la notion de « dictature de la commodité » (Citton, Lechner & al., 2023, p. 130-131) Citton, Y., Lechner, M. & Masure, A. (dir.). (2023). Angles morts du numérique ubiquitaire: glossaire critique et amoureux. Les Presses du réel. renvoie au fait de privilégier des interfaces plus commodes, tout en rognant sur des principes de maîtrise ou d’émancipation, dépassant largement le cas du logiciel avec les plateformes. De l’autre ce sont les interfaces truquées — ou dark pattern en anglais —, qui forcent l’utilisation des fonctionnalités plutôt que d’autres via des mécanismes graphiques. Qu’elles soient trompeuses ou non, les interfaces graphiques restent des enjeux de pouvoir sur les utilisateurs et les utilisatrices, le plus souvent guidés par des motivations économiques ou financières. Les mises à jour des logiciels sont l’occasion de proposer de nouvelles fonctionnalités mais aussi d’en faire disparaître d’autres, souvent tout simplement en les rendant moins accessibles. Si un bouton très visible et bien placé vous invite à imprimer un document depuis un traitement de texte, plutôt qu’à le convertir au format PDF, cela aura de fait une conséquence sur la consommation de papier.

L’enjeu des interfaces est particulièrement important pour les outils d’édition, ou justement le choix des formats n’est pas anodin comme nous l’avons vu précédemmentVoir 4. Les formats, structuration et modélisation du sens. L’édition a par ailleurs été un des premiers secteurs à voir arriver des solutions logicielles à interfaces graphiques.

#5.1.3. Logiciel et édition

Le développement de l’informatique ou du numérique est lié à l’évolution de l’édition, de la même façon que la technique et le livre ont une histoire commune comme nous l’avons déjà signaléVoir 3.2. Le livre numérique ou la pensée homothétique. La création de logiciels destinés à écrire et éditer se fait dans un contexte précis d’automatisation de certaines tâches dans toutes les strates de la société. Pour l’édition, il s’agit autant de faciliter et d’accélérer les opérations de saisie ou de composition, que de disposer d’outils plus puissants pour inscrire, structurer et agencer du texte. L’édition utilise donc très tôt — à l’échelle de l’histoire de l’informatique — des logiciels de toute sorte. Nous ne faisons pas ici une histoire des logiciels dans l’édition, nous signalons toutefois quelques moments clés avec l’apparition d’outils qui ont considérablement modifié ses processus et ses métiers. Pour cela nous nous appuyons sur le panorama établi par Julie Blanc et Lucile Haute (Blanc & Haute, 2018) Blanc, J. & Haute, L. (2018). Technologies de l’édition numérique. Sciences du design, 8(2). 11–17. https://doi.org/10.3917/sdd.008.0011 .

Plusieurs années d’expérimentation au Xerox PARC ont donné lieu à un certain nombre de prototypes ou de logiciels pour la production de documents imprimés. Ainsi entre 1969 et 1983, parmi les nombreuses inventions issues de ce lieu emblématique, mentionnons l’interface graphique qui y a été conceptualisée puis développée — Alan Kay a activement participé à ces travaux, nous revenons par la suite sur cette figureVoir 5.2. Contre le logiciel : pour des processus décomposés et ouverts —, ou le premier éditeur de texte WYSIWYG Bravo. D’autres structures ou entreprises proposent par la suite des logiciels inspirés directement ou indirectement de ces expérimentations pionnières. Suivent les premiers traitements de texte, comme WordPerfect en 1979, ou plus tard Microsoft Word en 1983, pour la gestion du texte. La composition est également informatisée avec les logiciels de publication assistés par ordinateur comme QuarkXPress en 1987, qui conserve une place hégémonique jusqu’à la fin des années 1990 avec l’arrivée de InDesign développé par Adobe. Ces initiatives ont en commun d’être entrepreunariales, il s’agit de créer puis de vendre des solutions informatiques pour la préparation de documents imprimés, ce qui comprend notamment l’édition. C’est donc toute une économie qui se met en place autour du logiciel et de l’édition, facilitant les différents processus, et introduisant de nouveaux paradigmes. Parmi ceux-ci, la gestion des calques a été une petite révolution comme le souligne Lev Manovich :

[The layers feature] redefines both how images are created and what an “image” actually means. What used to be an indivisible whole becomes a composite of separate parts. This is both a theoretical point, and the reality of professional design and image editing in our software society. […] Layers change how a designer or an illustrator thinks about images.

Ce n’est donc pas qu’une recherche de confort, ni une question de faciliter des opérations fastidieuses en milieu analogique, non plus une perspective d’une plus forte rentabilité, il s’agit aussi de nouvelles manières de créer. L’apport de ces logiciels implique aussi quelques contraintes. En effet les différentes options créées dans le logiciel sont autant d’occasions de diriger les comportements. Ce déplacement va donc plus loin, comme le décrit Anthony Masure dans sa thèse et plus particulièrement dans une partie dédiée :

PowerPoint, Word ou Photoshop sont paradigmatiques de l’emprise qu’exercent désormais les logiciels sur nos comportements. En se situant du côté du service et de l’usage, ils n’incitent pas à s’écarter d’une route tracée d’avance. Le logiciel conduit l’usager d’un point à un autre, sans détours et sans arrêts.

Les choix de fonctionnalités et d’interfaces inhérents à tout logiciel, résulte immanquablement à un certain degré d’opacité dans le fonctionnement ou dans la conception de tout logiciel.

#5.1.4. L’opacité induite par les logiciels

Une tension existe donc entre l’omniprésence de l’ordinateur comme outil d’écriture et d’édition via les logiciels d’une part, et les limitations de maîtrise de la machine du fait même de la nature du logiciel d’autre part. Dit autrement, sous couvert de rendre facilement utilisables les fonctions des programmes, voire d’assurer la sécurité de l’ensemble, les logiciels brident la connaissance et la maîtrise de l’informatique. Cette critique est fortement inscrite dans le mouvement dit du logiciel libre, où l’ouverture du code est une condition non négociable pour s’émanciper en tant qu’individu dans la société contemporaine, et avec le numérique. Cette tension est exprimée aussi en prenant en considération ce qu’est le logiciel en soi et au regard du développement de l’informatique, comme le fait Friedrich Kittler en 1995 dans son texte « There is No Software » (Kittler, 1995) Kittler, F. (1995). There is No Software. CTheory. 147–155. Consulté à l’adresse https://journals.uvic.ca/index.php/ctheory/article/view/14655 (traduit en français vingt ans plus tard (Kittler & Vargoz, 2015) Kittler, F. & Vargoz, F. (2015). Le logiciel n’existe pas. Dans Mode protégé. (pp. 29–45). Les Presses du réel. ).

Friedrich Kittler part du constat que des entreprises font tout leur possible pour « dissimuler » le matériel, le hardware, derrière le logiciel. Les raisons de cette dissimulation, malgré un discours qui vante l’efficacité ou la rapidité, sont fondamentalement commerciales. Parmi plusieurs de ses argumentations radicales, Friedrich Kittler souligne qu’alors que l’interaction avec la machine était possible en formulant des instructions via de « simples » lignes de commandes, les interfaces graphiques viennent donner un accès dit « direct » aux fonctions des programmes tout en rendant impossible toute autre forme d’« acte d’écriture ». Cela se traduit également concrètement par des limitations apposées sur les processeurs, avec le « mode protégé » qui empêche d’atteindre les fonctions du matériel, les grandes entreprises de l’informatique clamant ici des raisons sécuritaires — le risque évoqué étant que si aucune limitation n’est imposée les instructions peuvent endommager le matériel lui-même.

Pour Friedrich Kittler, le logiciel n’existe pas du point de vue des machines, c’est-à-dire de la théorie de l’information et du hardware, pour laquelle la seule réalité est l’inscription du réel en code binaire. Et puisqu’il n’existe pas, il n’y a, en conséquence, aucune raison pour qu’il soit brevetable. […] Le logiciel ne peut alors se vendre qu’en s’inféodant les machines, qu’en les recouvrant d’un nuage symbolique et culturel qui dissimule sa réalité. Le logiciel appartient non pas au réel mais au symbolique. Il n’existe que dans un système d’inscription donné, dont la réductibilité binaire lui interdit d’accéder au statut de texte.

Ce qui nous amène à considérer le programme plutôt que le logiciel comme outil permettant d’effectuer des calculs et donc des tâches sur une machine informatique tout en conservant une certaine part de contrôle. Parmi d’autres médias, l’informatique, avec le logiciel, contribue à conserver la « dichotomie fondamentale entre usage et maîtrise » (Guez & Vargoz, 2015, p. 17) Guez, E. & Vargoz, F. (2015). Kittler et les machines d’écriture. Dans Mode protégé. (pp. 7–24). Les Presses du réel. . Il ne s’agit pas ici de considérer l’assembleur comme premier accès à la machine informatique comme le prône Friedrich KittlerUne telle pratique nous permettrait toutefois d’acquérir une meilleure compréhension de nos environnements numériques., pas plus que d’envisager le terminal et ses lignes de commande comme seul mode d’accès au numérique, mais de remettre en cause le logiciel comme unique approche d’écriture ou d’édition informatique possible.

En résonance de ces considérations dans le champ de la théorie des médias, nous pouvons analyser deux autres dimensions à l’origine de l’opacité inhérente de tout logiciel : la fermeture du code ou son niveau de complexité. Nous l’avons déjà mentionnéVoir 3.1. Le numérique : culture, politique et ubiquité, l’utilisation des logiciels ou des programmes est légalement encadrée par l’attribution d’une licence. Celle-ci peut autoriser ou interdire la lecture du code informatique de ces objets numériques. Dans le cas du logiciel propriétaire qui empêche de voir comment le programme ou le logiciel a été conçu et donc fonctionne, une quelconque appropriation est évidemment impossible. Pour les entreprises qui commercialisent des logiciels, l’enjeu est de cacher les détails de fonctionnement pour garantir leur monopole. Attention toutefois à ne pas conclure que la simple ouverture du code permettrait aux utilisateurs et aux utilisatrices d’acquérir automatiquement une maîtrise de ces outils. Le logiciel libre ne résout pas tout, si les licences ouvertes ou libres autorisent la consultation des sources, encore faut-il que celles-ci soient suffisamment lisibles ou accessibles. Un haut niveau de complexité des logiciels empêche également leur compréhension. Si un logiciel comprend des centaines de composants — des micrologiciels ou des bibliothèques de code développées par ailleurs —, et que chacun d’entre eux est constitué de milliers de lignes d’algorithmes, une éventuelle entreprise d’appropriation se révèle impossible en temps — mais peut-être aussi en compétences. Ajoutons à cela le fait que l’interface graphique est le seul moyen d’interagir avec ce type d’outil, et il devient impossible de connaître les fonctions disponibles.

Le domaine de l’édition s’est très tôt posé les questions d’indépendance et de liberté, l’objectif étant de disposer de formats de travail interopérables pour pouvoir changer d’outil lorsque cela est nécessaire, mais aussi de construire des logiciels libres que tout le monde peut utiliser ou adapter, sans condition (ou presque). De nombreux logiciels ont ainsi été développés dans cette optique, d’abord par des communautés non nécessairement liées à l’édition avec par exemple la suite LibreOffice, puis par des professionnels du domaine comme dans le cas du logiciel Scribus. Scribus, comme Gimp destiné à la retouche d’images, illustre cette volonté de construire des alternatives. Scribus s’est donc constitué comme une solution libre (et gratuite) à Adobe InDesign (et avant à QuarkXPress), reproduisant la majorité des fonctionnalités du logiciel propriétaire. Si cette initiative est un succès — considérant que les communautés d’utilisateurs et d’utilisatrices de ces deux logiciels n’ont rien de comparables, tant Adobe InDesign reste l’outil très majoritairement utilisé —, il se heurte aux mêmes problèmes que tout logiciel : c’est un logiciel (qui plus est à interface graphique). Scribus n’apporte pas de changement de paradigme — à part la licence du logiciel —, du fait de cette duplication assumée, mais aussi parce que l’équipe qui est chargée du développement et de l’évolution de ce logiciel est très réduite comparée à Adobe InDesign.

Alors que des tentatives émergent pour détacher les métiers de l’édition de la situation de monopole et d’enfermement d’Adobe, une tendance apparaît au début des années 2010 avec une évolution du logiciel vers une logique de service et d’abonnement. Le logiciel devient désormais une interface accessible via Internet, et via un navigateur web, l’idée étant de ne plus avoir à installer en local sur un poste informatique un ensemble de programmes qu’il faudra de toute façon mettre à jour. Il s’agit finalement de l’aboutissement de ce pour quoi le logiciel a d’abord été conçu, simplifier l’accès à une puissance de calcul, sans rien savoir de son fonctionnement ; les constats faits par Friedrich Kittler quinze ans plus tôt semblent alors d’autant plus tristement justes (Kittler, 1995) Kittler, F. (1995). There is No Software. CTheory. 147–155. Consulté à l’adresse https://journals.uvic.ca/index.php/ctheory/article/view/14655 .

#5.1.5. Des logiciels aux applications et aux services

Le logiciel n’est plus seulement l’accès privilégié aux capacités de calcul d’un ordinateur, il se reconfigure également sous la forme d’applications voire de services au contact d’Internet et du Web, masquant un peu plus son fonctionnement à ses utilisateurs et à ses utilisatrices. Le terme de logiciel fait référence à trois dimensions déjà évoquées que nous rappelons ici : il est composé d’un ensemble de programmes ; il dispose d’une interface utilisateur (le plus souvent graphique) pour déclencher des fonctions ; un environnement informatique spécifique est nécessaire pour son fonctionnement. Aux débuts de l’ère des logiciels, l’envoi d’un support physique pour l’installation voire la mise à jour d’un logiciel était une pratique courante. Si Internet a facilité l’accès aux fichiers nécessaires à leur installation, ce mode de connexion a incité les entreprises commerciales à délocaliser de plus en plus l’usage même du logiciel, par la nécessité d’être connecté pour disposer des mises à jour, pour contrôler l’achat d’une licence, ou par un passage à des applications entièrement en ligne — aussi appelées applications web.

Précisons d’abord ce qui est entendu par « application » : Anthony Masure détaille ce terme comme provenant des logiciels mis à disposition pour les premiers téléphones iPhone d’Apple. Ainsi une application est un logiciel dédié à une ou plusieurs tâches, conçu pour un environnement précis — ou système d’exploitation —, et distribué via un canal contraint (Masure, 2014, p. 168-170) Masure, A. (2014). Le design des programmes: des façons de faire du numérique. Thèse de doctorat, Université Panthéon-Sorbonne. Consulté à l’adresse http://www.softphd.com/ . Nous retenons le caractère limité de l’application en fonctionnalités ou en accès, ainsi que sa connexion à des services en ligne. L’application est ainsi un logiciel dont l’opacité, en termes de mode de diffusion et de connaissance de son fonctionnement, est encore plus importante. Prenons un exemple pour illustrer cela.

Dans le cas d’Adobe InDesign, une première étape a été la mise à jour via Internet, comme bon nombre de logiciels. La seconde a été d’imposer une connexion pour activer et se servir du logiciel, pratique également répandue à bien d’autres logiciels ou systèmes d’exploitation. Ainsi le modèle économique d’Adobe a basculé de la vente d’un produit à l’abonnement à un service. Pour utiliser Adobe InDesign il n’est donc plus possible d’acheter une fois le logiciel, pour ensuite en faire usage sur une durée relativement longueCette durée correspond en fait à la période où la version du logiciel est compatible avec le système d’exploitation., mais de payer chaque mois un accès à ce logiciel. Les fichiers nécessaires au fonctionnement du logiciel restent sur l’ordinateur de l’utilisateur ou de l’utilisatrice, mais il est connecté aux serveurs d’Adobe, l’entreprise vérifiant par là même la présence d’une clé de licence autorisant la personne à se servir du logiciel. Les arguments d’Adobe dans cette situation relativement inédite, sont la garantie de mises à jour fréquentes, et l’ajout de services en ligne comme un espace de stockage et de sauvegarde sur les serveurs de l’entreprise. Espace dont l’accès est automatiquement coupé en cas d’arrêt de l’abonnement.

Des choix plus radicaux ont été réalisés dans le cas des applications web, considérées comme des Software as a Service (SaaS), déléguant totalement leur fonctionnement à une connexion internet et à un navigateur web. Plus besoin d’installer un logiciel sur un ordinateur, l’application web est en fait disponible sur un serveur via le navigateur web qui sert alors d’interface. En plus de l’opacité engendrée par le fait qu’aucun composant (ou presque) du logiciel n’est installé sur la machine de la personne qui l’utilise, les données elles-mêmes restent elles aussi sur ledit serveur. Sans parler des mises à jour sur lesquelles l’utilisateur ou l’utilisatrice n’ont plus leur mot à dire, des modifications des interfaces pouvant être imposées à tout moment. Il n’est plus question de logiciel propriétaire VS logiciel libre, certaines entreprises mettant même à disposition le code source de ces applications. C’est l’usage de l’instance sur leur serveur qui représente des coûts ou plutôt qui devient un produit. Il ne s’agit plus de payer directement des efforts pour créer et maintenir un logiciel, mais de financer le service correspondant — ou de le rendre suffisamment rentable. Le fait de pouvoir se départir de toute nécessité d’installation engendre une relative ouverture, ainsi les communautés du logiciel libre ont construit des applications comme alternatives à la fois aux logiciels propriétaires et aux applications des grandes entreprises du numérique qui retiennent captives les utilisateurs et les utilisatrices et leurs données. L’enjeu est donc désormais de savoir où sont hébergées les données, et si les formats sont interopérables pour pouvoir changer d’outil un jour. Nous constatons donc autant le déplacement d’une économie du logiciel — pourtant jusqu’ici bien portante — vers des applications ou des services en ligne sous forme d’abonnement, mais aussi la construction d’espaces ouverts et libres.

Quoi qu’il en soit, il y a selon nous une nécessité de se départir du logiciel ou de l’application. Les logiciels sont majoritairement pourvus d’interfaces graphiques utilisateur encombrantes qui sont souvent l’objet de dissimulations volontaires ou contingentes. En effet, l’opacité induite par ce qu’est le logiciel même nous rend tributaires de choix fonctionnels dont nous ne pouvons pas avoir connaissance. Les capacités de la machine sont cachées, toute volonté de comprendre comment elle fonctionne est annihilée. La délocalisation du logiciel sous la forme d’application en ligne supprime par ailleurs de façon absolue toute possibilité de modification du comportement du logiciel, celle-ci étant de la décision d’un tiers — qu’il soit commercial ou à but non lucratif. Faisant ces constats, des individus, des collectifs ou des structures ont mis en place des moyens de s’extraire de cette situation pour envisager d’autres modalités de faire. Avant de les analyser dans une prochaine section, faisant fi du logiciel, arrêtons-nous sur une définition stable dans le cadre de notre recherche :

Définition Logiciel

Liste des conceptsLe logiciel est compris ici comme un objet numérique permettant de réaliser des opérations de calcul grâce à un ordinateur. Le logiciel est l’interface — par ailleurs souvent graphique — entre un utilisateur ou une utilisatrice et des programmes, ces derniers étant eux-mêmes une suite d’algorithmes. Le logiciel est ubiquitaire, il a totalement façonné nos sociétés contemporaines. Le logiciel est une invention commerciale qui porte des valeurs marchandes plus qu’émancipatrices, cachant l’interaction avec la machine sous couvert de rapidité et de facilité. Son opacité nous conduit à le considérer comme une boîte noire dont le traitement des informations n’est pas toujours révélé, en raison de son code propriétaire ou de sa complexité inhérente. La documentation qui accompagne le logiciel n’est pas écrite pour comprendre ses modalités intrinsèques, mais uniquement pour aboutir à un fonctionnement, fonctionnement qui est rarement compatible avec une appropriation ou à un apprentissage. Par extension, un logiciel peut aussi être une application — dans le cas d’environnements encore plus fermés —, ou un service en ligne — pour une délocalisation totale. Le logiciel est ici distingué du programme, ce dernier étant une partie d’un logiciel, et pensé comme un composant pouvant être arrimé à d’autres programmes.

#5.2. Contre le logiciel : pour des processus décomposés et ouverts</>

Commit : 0b550b1

Source : https://src.quaternum.net/t/tree/main/item/content/p/05/05-02.md

</>

Commit : 0b550b1Source : https://src.quaternum.net/t/tree/main/item/content/p/05/05-02.md

Le logiciel pose plusieurs problèmes épistémologiques, son influence sur nos interactions numériques en général et sur les pratiques d’édition en particulier est importante, et nous mène à considérer la mise en place de processus qui ne font tout simplement pas appel au logiciel — tel que défini dans la section précédente. Plutôt que de poser la question d’une possibilité de travailler sans le logiciel, nous interrogeons les conditions et les implications de ces choix, qui sont des choix techniques, politiques mais aussi éditoriaux. Il s’agit donc d’une remise en cause du logiciel comme devant être central dans les pratiques d’édition. Comment ont émergé des processus qui ne sont plus centrés sur les logiciels et leurs interfaces ? Qu’est-ce qu’implique de ne plus recourir à des logiciels — propriétaires ou libres — dans des pratiques d’édition ?

De telles initiatives existent, nous identifions leur intervention à deux moments principaux de l’histoire de l’informatique, deux moments que nous souhaitons confronter pour comprendre les changements de paradigmes induits. D’une part au moment de l’émergence de l’informatique personnelle et le rôle que les interfaces ont pu y jouer. D’autre part dans des pratiques de design graphique (touchant à l’édition) qui se sont réinventées en délaissant volontairement le logiciel, après un passage par le logiciel libre. Nous intégrons ici un domaine lié à l’édition mais dont le champ est plus large : le design graphique. C’est un terrain pertinent pour observer des usages métiers dans l’édition, du fait de sa place décisive dans la chaîne de fabrication et de production, comme nous l’avons vu sur les questions de forme du livreVoir 1.2. La forme du livre et sa matérialité, et parce que la technique y est régulièrement interrogée.

Notre réflexion nourrit l’idée selon laquelle une fabrique d’édition est le lieu de recherches et d’expérimentations, et que cette double dimension est difficilement compatible avec le carcan imposé par les logiciels. L’adaptation ou la modification des logiciels connaît une certaine limite, tant les compétences en développement doivent être importantes, alors que la mise en place de scripts ou de programmes est une voie plus atteignable dans certains langages de programmation comme JavaScript, PHP ou Python. C’est donc contre le logiciel que des pratiques se développent, contre dans le sens d’une opposition, mais aussi d’un appui, le désir de prolonger des expérimentations au-delà du logiciel et du logiciel libre découle d’une forme de déconstruction. Il s’agit de décomposer et d’ouvrir. Conduire des instructions éditoriales en privilégiant le texte plutôt que des interactions via des interfaces graphiques — autrement dit des boutons —, peut par ailleurs être considéré comme un troisième niveau après le balisage sémantique et l’acte éditorial sémantique. Il s’agit alors de construire un outil qui traduit lui-même un sens dans sa conception et son fonctionnement, en lien avec le balisage sémantique du texte et la modélisation de l’édition.

#5.2.1. Une histoire des pratiques (presque) sans logiciel

Le logiciel, tel que décrit dans la section précédenteVoir 5.1. Les chaînes d’édition : composer avec les logiciels, est issu d’une évolution de l’informatique que nous devons approfondir en faisant un retour historique sur les premières initiatives autour de l’informatique personnelle, et en particulier sur l’expérience du dispositif Dynabook et du langage de programmation Smalltalk qui ont amené cette double idée d’une interface révélatrice des options offertes et d’un environnement programmable. Cet exercice exploratoire est utile pour comprendre comment les logiciels et leurs interfaces ont pris un virage spécifique, tronquant des principes ouverts pourtant présents dès les années 1960 et limitant ainsi une maîtrise de l’informatique. C’est l’objet des recherches du fameux centre de recherche de Xerox à Palo Alto (ou PARC pour Palo Alto Research Center) (Rheingold, 2000) Rheingold, H. (2000). Tools for thought the history and future of mind-expanding technology. MIT Press. , et plus spécifiquement du projet du Learning Research Group dirigé par Alan Kay, figure pionnière de l’informatique.

Alan Kay, Adele Goldberg, et leur équipe, ont travaillé plusieurs années sur le développement d’un dispositif informatique permettant de gérer de l’information au sens large, et plus spécifiquement de créer des outils de création de contenu variés (texte, image, animation et son). De 1967 à 1969, un dispositif matériel est imaginé, et un langage de programmation est développé, pour appliquer l’idée selon laquelle l’informatique pourrait être un méta-médium de création par le biais de la simulation d’autres médiums. Il s’agit donc d’une expérience épistémologique qu’un groupe de chercheurs et de chercheuses développe afin d’appliquer le principe de « métamédias » :

La plupart des appareils numériques que nous utilisons quotidiennement fonctionnent comme des media, en ce sens qu’ils permettent de transmettre, d’enregistrer et/ou traiter de l’information. Il paraît toutefois plus judicieux de les identifier au sein d’une classe particulière d’appareils de médialité qu’Adele Goldberg et Alan Kay ont proposé d’appeler « métamédias ». Ils caractérisaient de cette façon les media numériques par leur capacité à simuler tous les autres types de média préexistants. Ce sont des métamédias en ce sens que ce sont des media qui incluent en eux les autres medias et les re-médient de multiples façons.

Il faut replacer cette expérimentation dans son contexte. La fin des années 1960 est le moment d’une forte émulation intellectuelle autour des médias, et du développement de l’informatique. Cette période est particulièrement bien décrite par Fred Turner dans Aux sources de l’utopie numérique (Turner, Vannini & al., 2021) Turner, F., Vannini, L. & Cardon, D. (2021). Aux sources de l’utopie numérique: de la contre-culture à la cyberculture, Stewart Brand, un homme d’influence. C&F éditions (2012). , où plusieurs initiatives se croisent, se rencontrent ou s’entrechoquent. Les réflexions de Marshall McLuhan ou Buckminster Fuller sur les médias influencent nombre de communautés, dont les recherches des informaticiens et des informaticiennes du centre de Palo Alto :

I named the notebook-sized computer idea the Dynabook to capture McLuhan’s metaphor in the silicon to come.

Dans Personal Dynamic Media (Kay & Goldberg, 1977) Kay, A. & Goldberg, A. (1977). Personal Dynamic Media. Computer, 10(3). https://doi.org/10.1109/C-M.1977.217672 , Adele Goldberg et Alan Kay décrivent une expérience menée auprès d’enfants avec le Dynabook, un dispositif informatique portable, et avec Smalltalk, un langage de programmation orienté objet. Leur idée centrale est de créer un environnement, basé sur l’informatique, suffisamment ouvert pour permettre tout type de pratiques médiatiques ou artistiques, comprenant la création des outils par les utilisateurs et les utilisatrices elles-mêmes :

The burden of system design and specification is transferred to the user. This approach will only work if we do a very careful and comprehensive job of providing a general medium of communication which will allow ordinary users to casually and easily describe their desires for a specific tool.

Ce qui est développé à cette période rassemble tous les principes de l’informatique personnelle, telle que nous la connaissons encore aujourd’hui : interface graphique, souris avec un pointeur, supports de stockage, etc. Toutefois les logiciels tels que pensés ici divergent de la définition que nous avons donnée précédemment, il s’agit d’une période intermédiaire où les premières interfaces sont développées tout en conservant des modes d’interaction via des commandes textuelles.

All of the systems [writing, editing, drawing, doing animation or music, programming] are equally controllable by hand or by program. Thus, drawing and painting can be done using a pointing device or in conjunction with programs which draw curves, fill in areas with tone, show perspectives of three-dimensional models […], and so on.

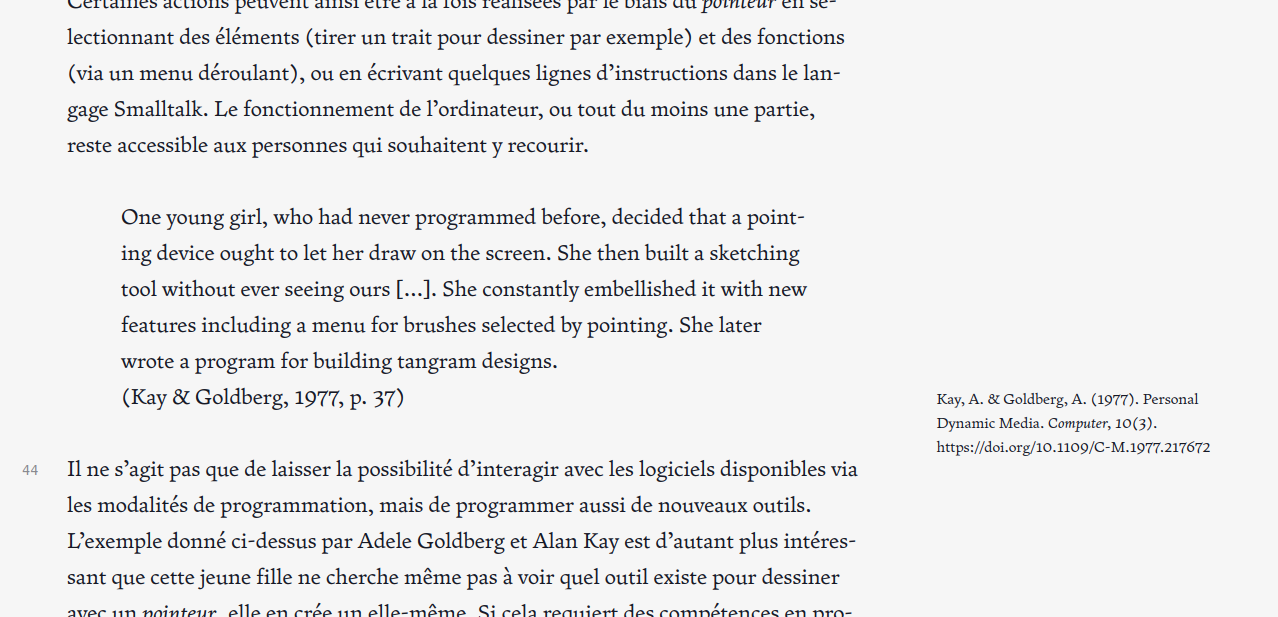

Les modalités d’interaction ne se limitent donc pas à une interface graphique qui, comme nous l’avons vuVoir 5.1. Les chaînes d’édition : composer avec les logiciels, est opaque par défaut. L’environnement logiciel du Dynabook, permis par Smalltalk, est pensé à la fois comme une facilitation des habituels modes d’interaction par la programmation, mais aussi comme un contrôle de la machine « par la main » — pour reprendre les mots d’Alan Kay et Adele Goldberg. Certaines actions peuvent ainsi être à la fois réalisées par le biais du pointeur en sélectionnant des éléments (tirer un trait pour dessiner par exemple) et des fonctions (via un menu déroulant), ou en écrivant quelques lignes d’instructions dans le langage Smalltalk. Le fonctionnement de l’ordinateur, ou tout du moins une partie, reste accessible aux personnes qui souhaitent y recourir.

One young girl, who had never programmed before, decided that a pointing device ought to let her draw on the screen. She then built a sketching tool without ever seeing ours […]. She constantly embellished it with new features including a menu for brushes selected by pointing. She later wrote a program for building tangram designs.

Il ne s’agit pas que de laisser la possibilité d’interagir avec les logiciels disponibles via les modalités de programmation, mais de programmer aussi de nouveaux outils, ou de programmer des pratiques. L’exemple donné ci-dessus par Adele Goldberg et Alan Kay est d’autant plus intéressant que cette jeune fille ne cherche même pas à voir quel outil existe pour dessiner avec un pointeur, elle en crée un elle-même. Si cela requiert des compétences en programmation qui peuvent sembler difficiles d’accès, Alan Kay et Adele Goldberg précisent bien que les jeunes utilisateurs et utilisatrices qui utilisent Dynabook — ou plus précisément interim Dynabook —, ont les capacités et l’envie de programmer, notamment du fait que cette expérience leur procure un « énorme sentiment d’accomplissement ». Cela fait partie des usages inattendus de cette expérience.

Si l’expérimentation présentée ici ne relève pas directement de pratiques d’édition, elle n’en demeure pas moins une initiative dans le champ de la gestion de l’information et de la création de contenus. Le duo Dynabook et Smalltalk présente donc un intérêt substantiel qui vient confirmer l’idée selon laquelle le logiciel ne doit pas forcément être le mode d’interaction unique pour créer. Mais que s’est-il ensuite passé pour que les principes de ce projet quelque peu utopique mais néanmoins concret n’aient pas perduré par la suite ? Le développement des interfaces utilisateurs (graphiques) a pris un tournant que le même Alan Kay critique plus de dix plus tard, et c’est ce que nous analysons désormais.

#5.2.2. Au centre l’interface

Si nous abordons la question des interfaces — champ d’études lié au logiciel —, c’est pour constater une évolution entre les débuts de l’informatique et la nécessité d’alors de programmer pour interagir avec la machine, et une omniprésence plus récente des logiciels et de leurs interfaces comme accès unique au numérique. Notre argumentation ne porte pas sur un retour à la programmation pour n’importe quelle (inter)action numérique, mais sur un dévoilement des rouages informatiques et d’une possibilité de reconfiguration du médium informatique afin de disposer d’une maîtrise permettant l’émergence de nouveaux modèles épistémologiques via des pratiques éditoriales. Dans ce cadre les logiciels et leurs interfaces utilisateur sont des éléments déterminants. Avant d’explorer plusieurs initiatives éditoriales qui s’opposent au logiciel, et des pratiques créatives basées sur le code, nous exposons les critiques d’un des pionniers de l’ordinateur personnel et des interfaces, Alan Kay.

Plus de dix ans après son article co-écrit avec Adele Goldberg, Alan Kay propose un texte pour un ouvrage collectif sur les interfaces (Laurel & Mountford, 1990) Laurel, B. & Mountford, S. (dir.). (1990). The art of human-computer interface design. Addison-Wesley Pub. Co.. . Cet article (Kay, 1990) Kay, A. (1990). User Interface: A Personal View. Dans Laurel, B. & Mountford, S. (dir.), The art of human-computer interface design. (pp. 191–207). Addison-Wesley Pub. Co.. est l’occasion pour lui de revenir sur les travaux qu’il a menés avec son équipe au Xerox PARC de Palo Alto autour du Dynabook, et les motivations sous-jacentes. Il est ici question de considérer l’informatique — et l’ordinateur — non pas comme un outil ou un véhicule mais comme un médium. La notion d’agent est essentielle dans cette conception empreinte de la pensée de Marshall McLuhan.

La réflexion d’Alan Kay est aussi nourrie par des lectures en psychologie, prenant en compte des capacités d’apprentissage dans la définition des éléments d’interaction constituant des interfaces. L’enjeu est délicat dans un contexte où la programmation pure a encore une place importante, comme nous avons pu le voir avec des systèmes programmatiques de composition comme (La)TeX.

The challenge would be to produce a language in which the act of programming produces within it an understandable explanation.

Le concept d’agent intervient justement pour faire le lien entre la machine et les personnes qui y ont recours. À travers cette conceptualisation Alan Kay critique en creux d’autres démarchesAu moment où Alan Kay rédige ce texte il travaille pour Apple, cela explique probablement une certaine retenue dans ses formulations que nous pouvons deviner comme très critiques. devenues à la fois complexes dans leurs finalités, et opaques dans leur adaptabilité. Pour expliciter cela Silvio Lorusso paraphrase ainsi Alan Kay :

[…] les choses simples ne sont pas restées simples et les choses compliquées sont devenues moins possibles.

Sans faire ici un compte-rendu exhaustif sur ce texte foisonnant d’Alan Kay, nous retenons l’idée selon laquelle l’environnement ou le dispositif doit être appropriable, et cette appropriation passe d’une certaine façon par un acte de programmation dont il fait mention à plusieurs reprises :

While designing the FLEX machine I had believed that end users needed to be able to program before the computer could become truly theirs […].

Le positionnement d’Alan Kay est en cela proche de celui de Friedrich Kittler, la différence se faisant sur l’application de ce principe d’écriture utilisé par ce dernier. Alan Kay articule des éléments d’interfaçage avec une pratique de la programmation, il s’agit de commencer par le concret pour ensuite passer à l’abstrait, ou de faire usage de moyens iconiques (icônes, fenêtres) pour permettre un passage au symbolique (langage de programmation orienté objet), aboutissant au slogan : « Doing with Images makes Symbols » (Kay, 1990, p. 196) Kay, A. (1990). User Interface: A Personal View. Dans Laurel, B. & Mountford, S. (dir.), The art of human-computer interface design. (pp. 191–207). Addison-Wesley Pub. Co.. . Smalltalk est pensé justement comme un langage de programmation suffisamment accessible et modulaire pour permettre à des enfants de le maîtriser pour toute sorte d’applications. Ce lien entre interface utilisateur et programmation se retrouve dans d’autres travaux de recherche et dans des expérimentations, comme le travail particulièrement novateur de Muriel Cooper au MIT sur les interfaces graphiques (Maudet, 2017) Maudet, N. (2017). Muriel Cooper, Information Landscapes. Back Office(1). Consulté à l’adresse http://www.revue-backoffice.com/numeros/01-faire-avec/nolwenn-maudet-muriel-cooper-information-landscapes .

Comme l’a souligné Silvio Lorusso dans son article « Liquider l’utilisateur » (Lorusso, 2021) Lorusso, S. (2021). Liquider l’utilisateur. Tèque(1). 10–57. https://doi.org/10.3917/tequ.001.0010 , les concepts développés par Alan Kay et son équipe sont loin d’avoir été appliqués dans les logiciels tels que nous les utilisons majoritairement aujourd’hui. Pourtant d’autres pratiques, fortement liées à l’édition, émergent en réaction à cette hégémonie du logiciel et à une forme d’uniformisation des pratiques qui en est induite. Après avoir exploré comment les logiciels et leurs interfaces sont apparus, et critiqués leur usage massif, nous questionnons la façon dont il est possible d’éditer et de composer sans logiciel.

#5.2.3. Éditer et composer sans logiciel

L’édition est un domaine avec des pratiques logicielles globalement uniformes, pour la structuration et la composition. Pourtant, le design graphique est plus spécifiquement un domaine où des pratiques sans logiciel se développent. C’est ce que nous analysons ici avec la question de l’appropriation du code par des designers (et non des éditeurs) pour développer des pratiques (nouvelles ?) de création et de production (dont de l’édition).

Le numéro de la revue Graphisme en France de 2012 est un panorama de pratiques de designers que nous pouvons qualifier de non conventionnelles, en raison du choix ou de la constitution des outils de ces designers en dehors des pratiques majoritaires. Dans l’article « Code = design », Kévin Donnot arrive au même constat que le nôtre, une majorité de praticiens et de praticiennes utilisent les mêmes logiciels, et ceux-ci ont une influence sur leur démarche de création et sur les artefacts produits. Pourtant les pratiques artistiques sont historiquement habituées à ce que l’outil ait une place importante dans l’œuvre qui en résulte.

Pourquoi ne pas assumer cette influence et choisir un outil en fonction de son empreinte ? Ne faudrait-il pas s’interroger sur l’outil qu’il serait juste d’employer avant de se tourner machinalement vers son logiciel habituel ?

C’est encore une fois la question de la relation avec la technique qui intervient ici, le fait de modeler ses propres outils ou au moins de remettre en cause ceux qui sont imposés.

On peut alors envisager le design logiciel non plus comme une technique au sens réducteur du terme, mais comme partie intégrante du processus de design graphique.

Si les exemples donnés dans ce numéro de Graphisme en France relèvent majoritairement du design graphique et de la visualisation de données — notamment avec les possibilités du design génératif —, les questionnements soulevés par Kévin Donnot mais aussi par Annick Lantenois concernent plus globalement les modes de création et de production d’artefacts tels que le livre.

[…] ces textes de programmation sont de la pensée qui dicte – impose – les formes, les syntaxes, les structures et, globalement, l’environnement sensible de lecture et d’écriture. […] De la maîtrise de ce qui s’écrit dans ces programmes dépend donc la liberté de ceux (les designers graphiques) qui utilisent les logiciels, de ceux (les lecteurs, les utilisateurs) à qui sont destinés les « objets », les dispositifs conçus avec ces logiciels, et de tous ceux qui suivront après nous. Les logiciels propriétaires d’écriture, de lecture, de mise en pages, de traitement d’images et de sons, traduisent, par conséquent, la pensée des firmes éditrices.

Les logiciels propriétaires, et les logiciels tout court, peuvent être oubliés au profit de démarches plus ouvertes, considérant la programmation comme partie intégrante d’une démarche de design. C’est ce que confirment Julie Blanc et Nolwenn Maudet dix ans plus tard dans la même revue, avec une analyse des pratiques de programmation en design graphique. Il s’agit plus spécifiquement de recherches et de travaux autour de la composition de pages, et de l’influence d’une culture du Web sur la production d’artefacts imprimés. Ce Web est une occasion incroyable de repenser les modes de création et de production en design graphique.

Ainsi les designers graphiques codent-ils pour être au plus près des supports de lecture et de communication avec lesquels ils travaillent. […] Ces pratiques du code contribuent en même temps à dépasser les approches issues des logiciels à interfaces graphiques qui avaient poussé les designers graphiques à adopter l’informatique comme principal outil au début des années 1990.

Le collectif Open Source Publishing (OSP)http://osp.kitchen, cité à plusieurs reprises dans les deux textes, illustre cette démarche. OSP développe d’abord des pratiques autour du logiciel libre, puis crée ses propres outils via la programmation. Ce collectif a une place pionnière dans le mouvement dit du CSS print, qui émerge notamment en Belgique (Visscher, 2019) Visscher, A. (2019). Du design de la page à la pédagogie du flux : le cas belge. Back Office(3). 122–135. Consulté à l’adresse http://www.revue-backoffice.com/numeros/03-ecrire-lecran/10_devisscher et qui consiste à imprimer une page web pour produire des artefacts tels que des livresPlusieurs expressions définissent cette pratique, nous préférons CSS print à web to print (trop ambigüe) ou HTML to print (pas assez précise), puisqu’il s’agit d’utiliser le langage de mise en forme CSS pour concevoir et produire des documents paginés et des fichiers imprimables.. Autrement dit à utiliser les technologies du Web — HTML, CSS et JavaScript — pour mettre en forme des artefacts imprimés et générer les fichiers pour l’imprimeur. Les différentes personnes qui composent le collectif OSP créent des outils et mettent en place plusieurs processus de publication, utilisant certaines fonctionnalités bien précises du langage CSS et des navigateurs webIl s’agit plus spécifiquement des modules CSS « CSS Paged Media Module Level 3 » et « CSS Generated Content for Paged Media Module », standards développés depuis 1999 : https://www.w3.org/TR/css-page-3/ et https://www.w3.org/TR/css-gcpm-3/. pour produire des documents paginés (posters, brochures, livres, etc.). Il s’agit autant d’une démarche d’émancipation des logiciels en général et des logiciels dits propriétaires en particulier, qu’une volonté de construire leurs propres outils et de les rendre disponibles à tous.

Nous retenons trois éléments primordiaux dans ce dialogue entre ces deux textes et ses pratiques, qui s’étalent sur plus de dix ans dans le champ du design graphique : la marque de l’outil dans les créations, la démarche adaptative, et la perspective positive de ces initiatives. Ces façons de faire non conventionnelles donnent tout d’abord un souffle nouveau aux identités graphiques elles-mêmes. En plus d’être une occasion de créer des outils sur mesure, les artefacts générés peuvent conserver une empreinte graphique et visible de procédés génératifs, de programmes ou de polices typographiques non finalisées, ou de filtres inédits. Ensuite ces démarches sont nécessairement adaptatives, il ne s’agit pas de créer de nouveaux instruments de zéro, mais de trouver des moyens d’adapter certains logiciels ou composants existants pour la pratique du design graphique — et notamment la composition de pages. C’est également ce que décrit Nolwenn Maudet lorsqu’elle constate une « inadéquation » entre des designers et leurs outils, et qu’une piste de résolution pertinente est la programmation (Maudet, 2018) Maudet, N. (2018). Reinventing Graphic Design Software by Bridging the Gap Between Graphical User Interfaces and Programming. Design Research Society Conference 2018. https://doi.org/10.21606/drs.2018.611 . Enfin, les différents entretiens ou témoignages de designers programmeurs et programmeuses ont en commun de révéler un rapport positif avec la technique dans la création ou l’adaptation d’outils. Il s’agit d’une disposition constructive intégrée à la pratique du design graphique en général.

[…] for me it’s more like a collection of practices and the tools that support these practices. [Alexandre Leray]

À l’injonction productiviste qui vient s’infiltrer jusque dans des pratiques liées à la fois à l’édition et au logiciel libre, se manifestant par la production d’outils prêts à servir, il y a une forme de désolidarisation des personnes qui pratiquent. Nous prolongeons l’analyse de l’usage des technologies du Web pour imprimer initié notamment par le collectif OSP.

#5.2.4. Imprimer dans le navigateur, les expérimentations pionnières d’Open Source Publishing

Parmi les expériences d’adaptation ou de création d’outils, celles d’Open Source PublishingPrécisons ici que l’auteur de cette thèse a eu l’occasion de travailler avec une membre d’OSP, Amélie Dumont, sur un projet éditorial commandité par l’Université Lyon 3, de septembre 2022 à octobre 2023. touchent plus spécifiquement à l’édition avec la mise en page de documents de type livre — ou paginés —, proposant des modalités éditoriales qui dépassent le design graphique, et qui révèlent un besoin et une envie de créer des outils et des environnements. À travers le mouvement dit du CSS print, et plus globalement du creative coding, nous analysons à quel point des pratiques d’édition se mêlent à la création d’outils non conventionnels. Dit autrement, comment des pratiques de design s’accompagnent-elles d’une démarche conjointe de développement d’outils ? Sans faire ici une étude de cas élaborée, nous relevons plusieurs éléments remarquables dans quelques projets et outils d’OSP.

Les expérimentations d’OSP autour de l’impression via un navigateur web commencent avec la production de livrets pour le Théâtre de la Balsamine en 2011. La collaboration entre ce commanditaire et OSP prend la forme d’une recherche d’identité graphique, de la production de documents paginés — un programme — et l’expérimentation d’outils non conventionnels d’édition et de publication. Dès les débuts de ce projet, qui se répète annuellement jusqu’en 2022, l’idée n’est pas que de proposer une nouvelle grammaire graphique pour la communication d’une structure culturelle, mais de repenser la façon d’éditer un document bien particulier qu’est un programme de théâtre. Les outils alors utilisés varient, passant du logiciel de PAO libre Scribus à des expérimentations avec les navigateurs web. À partir de 2013 OSP travaille avec les spécifications CSS Regions pour pouvoir mettre en pages des contenus d’habitude sous forme de flux, c’est le début du mouvement dit CSS print et la mise en place d’un workflow nommé « HTML2print ». L’idée est d’utiliser le langage HTML en tant que structuration sémantique, et le format CSS comme instructions de mise en forme, sans recourir à des logiciels autres que le navigateur pour aboutir à un document au format PDF. Si la collaboration avec le Théâtre de la Balsamine est l’occasion de tester de multiples approches, cette chaîne de traitement graphique et de production de documents paginés et imprimables « HTML2print » est ensuite par exemple systématiquement utilisée pour le magazine Médor à partir de 2015https://medor.coop.

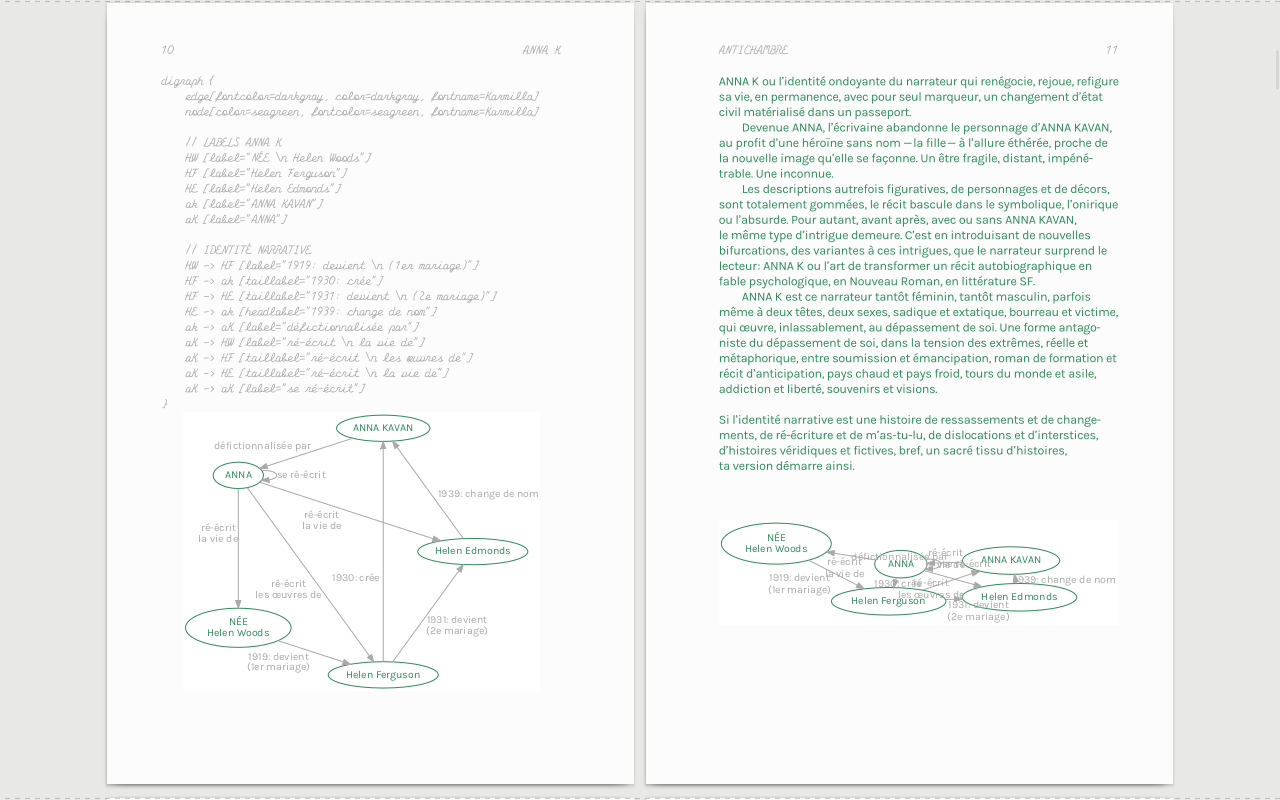

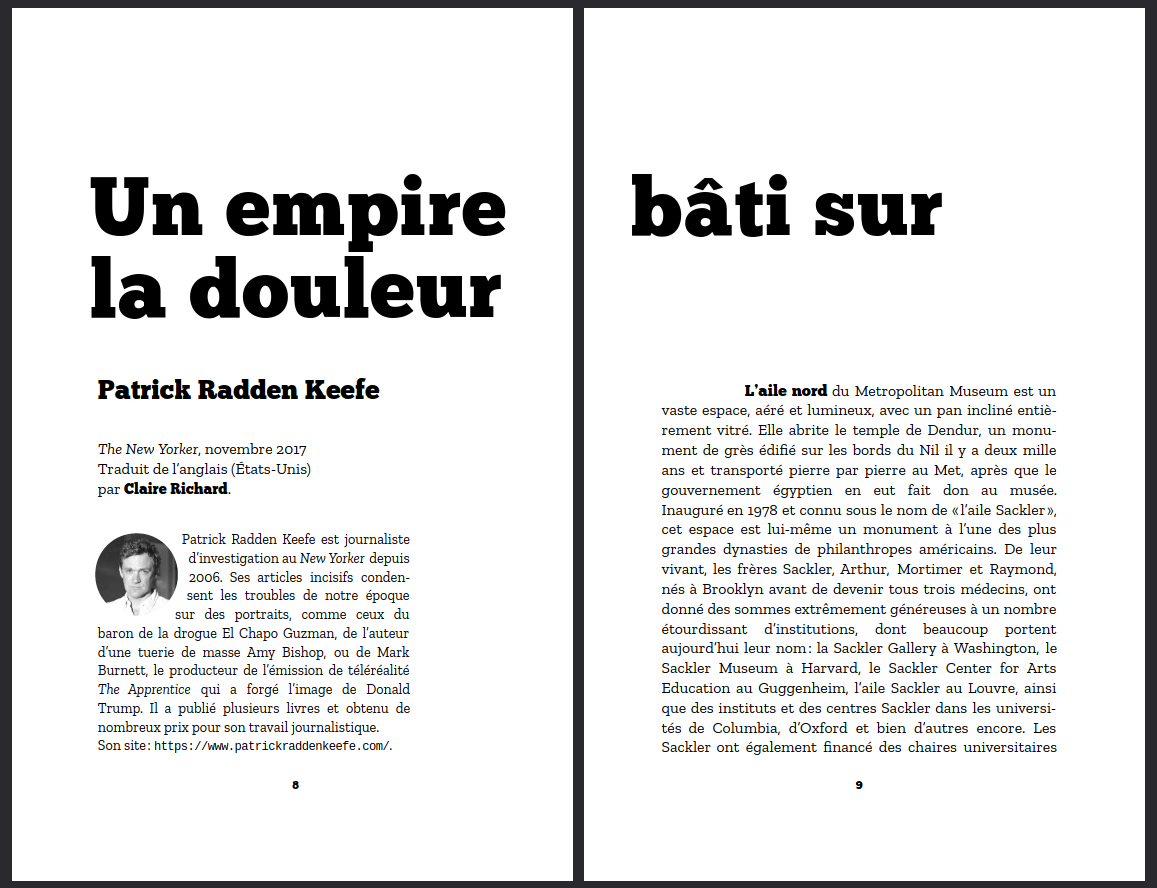

OSP s’implique ensuite dans plusieurs projets éditoriaux, dont un livre co-signé avec Catherine Lenoble aux éditions HYX, Anna K. Stéphanie Vilayphiou et Alexandre Leray, membres d’OSP, construisent avec Catherine Lenoble deux objets éditoriaux : un site web et un livre imprimé. L’implication des deux graphistes dans cette aventure éditoriale dépasse la composition ou la production d’un artefact, il s’agit aussi de produire des formes narratives graphiques faites de lignes de code ou de graphes, ce qui explique que le livre soit signé Catherine Lenoble et OSP. Tout est réalisé avec les technologies du Web, le logiciel est ici relégué au second plan, la majeure partie du travail éditorial passant par la modification du code — HTML, CSS et Python pour certaines manipulations.

Cet ouvrage est un exemple typique de publication multimodale telle que nous l’avons déjà évoquéeVoir 4.4. Le single source publishing comme acte éditorial sémantique, les deux objets étant néanmoins distincts pour leur production. Ce projet éditorial est également une occasion pour OSP d’affiner les outils développés pour produire des objets éditoriaux divers, ici l’usage de la spécification CSS Regions déjà évoquée. Point important, tous les projets d’OSP sont accompagnés d’une documentation, dans l’optique de pouvoir réutiliser les outils au sein du collectif mais aussi plus largement — les licences qui accompagnent ces bouts de code sont très permissifs. Aussi, un blog documente d’un point de vue plus général les expérimentations diverseshttp://blog.osp.kitchen/.

Le collectif PrePostPrinthttps://prepostprint.org se constitue en 2017 à l’initiative de Raphaël Bastide et Sarah Garcin, faisant suite aux pratiques initiées par OSP. En effet, ces pratiques se répandent dans la communauté composite du design graphique, dans les studios et les écoles (principalement en Europe), comme une revendication forte d’adopter d’autres moyens que cette vision unique du logiciel telles que le décrivent Julie Blanc et Nolwenn Maudet dans leur article déjà cité (Blanc & Maudet, 2022) Blanc, J. & Maudet, N. (2022). Code <–> Design graphique: Dix ans de relations. Graphisme en France(2022). . Durant l’automne 2021 plusieurs présentations autour de l’usage des technologies du Web pour concevoir et produire des documents paginés et imprimés ont lieu dans le cadre de l’événement « Open Publishing Fest » organisé par Adam Hyde et Julien Taquet et soutenu par la Collaborative Knowledge Fondation (Coko)https://openpublishingfest.org. La « bibliothèque web to print », coordonné par Lucile Haute avec Quentin Juhel et Antoine Lefebvrehttp://2print.org s’inscrit également dans ce mouvement, recensant les multiples productions éditoriales paginées qui reposent sur les technologies du Web et une pratique du code. Un trait commun transparaît à travers ces initiatives : l’assemblage ou la création d’outils qui reposent sur le logiciel libre afin de prendre en compte des besoins formulés par celles et ceux qui pratiquent le design graphique, et non des contraintes imposées par des entreprises privées.

Une dernière question doit être posée ici : s’agit-il vraiment de créer des outils réutilisables ? Les efforts d’OSP, que ce soit pour les projets évoqués ci-dessus ou pour d’autres, se concentrent surtout sur les artefacts. Il arrive ainsi que certaines documentations soient incomplètes, ou que l’organisation des dépôts de code ne facilite pas la réutilisation de certains programmes ou micrologiciels. Comme l’a dit plus haut Alexandre Leray, il s’agit de documenter les pratiques et les outils qui les accompagnent, plus que de proposer des logiciels prêts à l’emploi. Cette démarche reflète une inscription dans la culture hacker, fondamentalement anticapitaliste, qui préfère ainsi mettre à disposition des productions sous des conditions qui permettent leur réutilisation, leur adaptation et souvent aussi leur finalisation, plutôt que formater des instruments éditoriaux. Cet usage créatif de la programmation, tournée vers la pratique plus que vers des solutions ou des produits, fait l’objet du développement qui suit.

#5.2.5. Se passer de logiciel, entre bricolage et pratiques collectives et collaboratives

La place de la programmation dans les pratiques de design graphique est un terrain particulièrement stimulant pour nos recherches, tant les corps de métier et les personnes qui les incarnent les font évoluer et révèlent de nouvelles modalités d’édition, des perspectives d’émancipation avec le numérique ou l’informatique. Après les deux numéros de Graphisme en France en 2012 et 2022, l’ouvrage Graphic Design in the Post-Digital Age: A Survey of Practices Fueled by Creative Coding (Conrad, Leijsen & al., 2021) Conrad, D., Leijsen, R. & Héritier, D. (dir.). (2021). Graphic Design in the Post-Digital Age: A Survey of Practices Fueled by Creative Coding (First edition). Onomatopee. questionne la relation du design graphique avec des pratiques de programmation. Ce travail de recherche, initié par la Haute école d’art et de design de Genève, regroupe deux essais et une série d’entretiens avec des designers dans le domaine du graphisme — le livre a été édité une première fois par Onomatopee en 2021 puis réédité par Set Margins’ en 2023 (Conrad, Leijsen & al., 2023) Conrad, D., Leijsen, R. & Héritier, D. (dir.). (2023). Graphic Design in the Post-Digital Age: A Survey of Practices Fueled by Creative Coding (Second edition). Set Margins'. . Si l’édition n’est pas au centre de cet ouvrage, c’est un sujet qui revient pourtant régulièrement, le livre ayant encore une place importante dans les pratiques du design graphique.

L’objet de Graphic Design in the Post_Digital Age est de récolter des témoignages de pratiques de programmation créative — ou creative coding — et d’apporter un regard critique sur ces initiatives. Si le graphisme était originellement artisanal et artistique, est-ce que la programmation pourrait devenir l’outil d’un nouveau type d’artisanat ? C’est la question que pose Demian Conrad dans l’introduction (Conrad, 2021) Conrad, D. (2021). Graphic Design in the Post-Digital Age: Introduction. Dans Conrad, D., Leijsen, R. & Héritier, D. (dir.), Graphic Design in the Post-Digital Age: A Survey of Practices Fueled by Creative Coding. (First edition, pp. 7–24). Onomatopee. . L’ère du logiciel, désormais en grande partie dominée par les produits d’Adobe dans le champ du design graphique, pourrait ainsi voir advenir une communauté hétérogène qui construit elle-même ses outils. Demian Conrad précise plusieurs postulats nécessaires pour comprendre une situation contemporaine, et notamment l’arrivée d’outils permettant de générer des formes graphiques comme Processing, ou encore la période post-digital comme point de départ d’hybridations entre imprimé et numérique.

Dans l’essai qui suit cette introduction, Silvio Lorusso apporte un regard critique bienvenu, distinguant deux postures antagonistes : apprendre à programmer ou programmer pour apprendre. Il y a une certaine pression économique, les compétences en programmation étant attendues par une société qui a besoin d’ouvriers du code plutôt que de bricoleurs créatifs. Silvio Lorusso insiste à juste titre sur la tension entre la programmation vue comme un gain de temps pour des opérations d’habitude longues, et la programmation comme processus d’apprentissage nécessairement lent :

This is the paradox of creative coding: the coding part is supposed to make things faster, the creative part requires that things go slowly.

La programmation, dans le cas du design graphique, est donc une pratique qui permet de repenser l’usage de l’informatique plutôt que d’automatiser toute sorte de tâches. Nous retrouvons là un motif déjà abordé avec l’approche des humanités numériquesVoir 3.4. Fondement de l’édition numérique au prisme des humanités numériques. Construire un environnement sans logiciels, ou en tout cas sans les outils dont la profession est assujettie, demande du temps. Ce cheminement est valorisé par des studios ou des collectifs qui, en plus d’apporter une identité graphique spécifique comme nous l’avons mentionné plus haut, amène aussi un nouveau cadre épistémologique à leurs commanditaires. C’est notamment ce qui ressort des entretiens qui suivent ces deux textes.

Nous notons plusieurs éléments récurrents dans les témoignages des vingt-deux designers ou collectifs, marquant à la fois les possibilités mais aussi les limites des outils ainsi créés. Le premier apport de la programmation, dans le design graphique en général, tient dans des outils créés sur mesure, et cela pendant la création. Dans le cas de l’édition il s’agit surtout d’avoir recours au CSS print, pour construire de nouvelles interfaces de travail : le navigateur web est à la fois le logiciel qui produit une version imprimée d’un site web — certes bien spécifique —, mais aussi le moyen de prévisualiser ce travail. Aussi, certaines des personnes interrogées signalent que les outils développés le sont également pour les commanditaires, toutefois ces derniers n’utilisent pas toujours ces instruments qui sortent quelque peu de l’ordinaire par rapport aux logiciels traditionnels, comme le rapporte notamment le collectif Luuse (Conrad, Leijsen & al., 2021, p. 291) Conrad, D., Leijsen, R. & Héritier, D. (dir.). (2021). Graphic Design in the Post-Digital Age: A Survey of Practices Fueled by Creative Coding (First edition). Onomatopee. . La question ici pourrait être de savoir si, dans ce cas, les personnes qui éditent ne doivent pas adopter la même démarche pour être en mesure d’utiliser elles-mêmes les outils ainsi créés. Enfin, parmi les multiples réflexions dont témoignent ces pratiques hétérogènes, une distinction est faite entre différents types de codes. De la même façon que Silvio Lorusso pointait la différence entre une profession (développeur) et une main-d’œuvre (codeur), Marianne Plano signale que le soin apporté au code diffère selon l’artefact créé. Dans le cas d’un artefact imprimé, le code pour parvenir à ce résultat peut rester incomplet, ce qui ne peut pas être possible pour un artefact qui est lui-même numérique.

If you use programming to create a poster and your code is a bit messy, it does not matter as long as the outcome is compelling, but if you are creating a website, the code has to work properly. [Marianne Plano, collectif Luuse]

Programmer sans être développeur ou développeuse de métier est possible pour constituer de nouveaux modèles éditoriaux et épistémologiques. Les outils créés ne sont ni vendus ni mis à disposition pour être réutilisés sans un effort de compréhension et d’adaptation, ce qui explique aussi que les éditeurs de logiciels commerciaux ne s’inquiètent probablement pas pour le moment de telles initiatives. Cet effort de décomposition et d’ouverture, initié pour fabriquer des processus hétérogènes, aboutit à des pratiques sans le logiciel. Dans le cas de l’édition, et plus spécifiquement du mouvement dit du CSS print, une bibliothèque de code est régulièrement citée dans les entretiens, il s’agit de Paged.jshttps://pagedjs.org/. Les origines et le fonctionnement de Paged.js, décrits dans la section suivanteVoir 5.3. L’édition libre de C&F à travers l’étude de cas de C&F Éditions, révèlent une intention collective pour permettre l’émergence d’un nouveau paradigme pour la composition et la mise en page de documents paginés autour de standards. Le développement de cette bibliothèque de code marque la nécessité de réunir des efforts divers autour du CSS print, de permettre de bricoler mais aussi de penser des environnements stables et durables, de rassembler les énergies dans le prolongement du logiciel libre. Loin d’être une uniformisation des pratiques comme nous avons pu l’observer avec certains logiciels dans l’édition, Paged.js est une occasion de réunir des initiatives plurielles, de faire converger les différentes expérimentations présentées dans cette section tout en laissant le champ des possibles — graphiques et processuels — ouverts. Il convient désormais d’interroger la cristallisation de ces pratiques dans le domaine de l’édition, et plus spécifiquement du côté d’une structure d’édition. Au-delà de la commande en design graphique, comment une maison d’édition est-elle en mesure de faire des livres sans logiciels ? C’est l’objet de la prochaine section sous la forme d’une étude de cas de C&F Éditions.

#5.3. L’édition libre de C&F</>

Commit : 63dfd2e

Source : https://src.quaternum.net/t/tree/main/item/content/p/05/05-03.md

</>

Commit : 63dfd2eSource : https://src.quaternum.net/t/tree/main/item/content/p/05/05-03.md

Comment une structure d’édition intègre-t-elle des pratiques d’édition sans logiciels ? Pour répondre à cette question nous analysons une chaîne d’édition mise en place et utilisée par la maison d’édition C&F ÉditionsL’auteur de cette thèse a réalisé plusieurs prestations de production de livres numériques au format EPUB en 2017 et 2018 pour C&F Éditions, sans pour autant participer aux projets présentés dans cette étude de cas. Antoine Fauchié a également été membre du comité des Rencontres internationales de Lure aux côtés de Nicolas Taffin en 2014 et 2015.. Cette étude de cas aborde une situation concrète de production éditoriale qui se passe de logiciel, qui s’en libère — ou tout du moins qui décompose un processus d’habitude entièrement dépendant d’un logiciel — avec toutes les implications que cela peut avoir : maîtrise du flux de composition éditoriale, indépendance vis-à-vis de logiciels propriétaires, création d’outils typographiques sur mesure, temps nécessaire à l’adaptation ou au développement de bibliothèques de code, nouvelles modélisations éditoriales, gestion de dettes techniques, etc.

Nous présentons tout d’abord la démarche globale de C&F ÉditionsDans la suite de l’étude de cas nous utilisons indistinctement les formulations « C&F » et « C&F Éditions »., tant en termes de catalogue (titres, collections, thématiques) que de vision de l’édition (notamment sur le droit d’auteur), passage indispensable pour comprendre les choix opérés depuis 2003. La collection « interventions » est le point de départ de l’application des principes du CSS print, ou le fait d’imprimer un livre depuis le navigateur. Il s’agit de comprendre comment la chaîne d’édition a été adaptée dans ce cas précis, puis d’étudier la myriade d’ajustements et d’outils développés autour de Paged.js. Enfin nous apportons un regard critique à cette démarche, en la reliant à d’autres initiatives éditoriales du même type. À travers cette étude de cas, nous interrogeons le lien entre la création des outils d’édition et l’édition elle-même. Autrement dit : à quel point C&F Éditions constituent une fabrique d’édition ?

#5.3.1. C&F, une maison d’édition pas comme les autres